Các nhà nghiên cứu của tập đoàn Intel đã phát triển công nghệ phát hiện Deepfake trong thời gian thực để giải quyết các mối đe dọa liên quan. Deepfake là video, đoạn ghi âm hoặc hình ảnh mà trong đó có người hoặc hành động không có thật được tạo bởi trí tuệ nhân tạo (AI). Deepfake sử dụng các kiến trúc học sâu phức tạp, chẳng hạn như mạng đối nghịch tạo sinh, các bộ mã tự động đa dạng và các mô hình AI khác, để tạo ra nội dung có độ chân thực cao và có vẻ đáng tin. Các mô hình này có thể tạo ra các tính cách nhân tạo, video ghép lời và thậm chí chuyển đổi văn bản thành hình ảnh, khiến việc phân biệt giữa nội dung thật và giả trở nên vô cùng khó khăn.

Thuật ngữ Deepfake đôi khi được áp dụng cho nội dung xác thực đã bị thay đổi. Các nhà nghiên cứu của Intel kiểm tra các dạng nội dung được tổng hợp bởi máy tính, đồng thời cho biết: “Lý do nó được gọi là Deepfake là vì có kiến trúc học sâu phức tạp trong AI tạo ra tất cả nội dung đó”.

Tội phạm mạng thường lạm dụng công nghệ Deepfake để thực hiện các hành vi bất chính. Một số trường hợp sử dụng bao gồm lan truyền thông tin chính trị sai lệch hoặc cá nhân không đồng thuận, thao túng thị trường và mạo danh để kiếm tiền. Những tác động tiêu cực này cho thấy sự cần thiết của các phương pháp phát hiện Deepfake hiệu quả.

Phòng thí nghiệm Intel đã phát triển một trong những nền tảng phát hiện Deepfake trong thời gian thực đầu tiên trên thế giới. Thay vì tìm kiếm một số dấu hiệu làm giả, công nghệ này tập trung vào việc phát hiện những gì là thực, chẳng hạn như nhịp tim. Sử dụng kỹ thuật Photoplethysmography - hệ thống phát hiện phân tích sự thay đổi màu sắc trong tĩnh mạch do hàm lượng oxy để có thể phát hiện xem người xuất hiện trong video là thật hay giả.

Công nghệ phát hiện Deepfake của Intel đang được triển khai trên nhiều lĩnh vực và nền tảng khác nhau, bao gồm các công cụ truyền thông xã hội, các cơ quan báo chí, đài truyền hình, công cụ tạo nội dung, công ty khởi nghiệp và tổ chức phi lợi nhuận. Bằng cách tích hợp công nghệ này vào quy trình làm việc, các tổ chức này có thể xác định và giảm thiểu tốt hơn sự lây lan các thông tin sai lệch liên quan đến Deepfake.

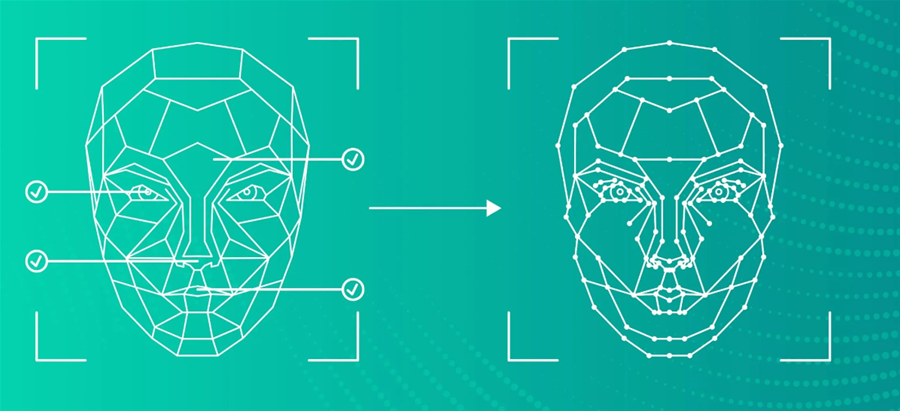

Mặc dù có khả năng bị lạm dụng nhưng công nghệ Deepfake có những ứng dụng hợp pháp. Một trong những ứng dụng ban đầu là tạo hình đại diện cho các cá nhân trong môi trường kỹ thuật số. Nhà nghiên cứu Ilke Demir của Intel đề cập đến một trường hợp sử dụng cụ thể có tên là "MyFace, MyChoice", tận dụng Deepfake để nâng cao quyền riêng tư trên các nền tảng trực tuyến.

Nói một cách đơn giản, phương pháp này cho phép các cá nhân kiểm soát sự xuất hiện của mình trong các bức ảnh trên mạng, thay thế khuôn mặt bằng một "Deepfake tương đối khác biệt" nếu họ muốn tránh bị nhận ra. Các biện pháp kiểm soát này giúp tăng cường quyền riêng tư và kiểm soát danh tính, giúp chống lại các thuật toán nhận dạng khuôn mặt tự động.

Đảm bảo việc phát triển và triển khai các công nghệ AI một cách có đạo đức là rất quan trọng. Nhóm Trusted Media của Intel có hợp tác với các nhà nhân chủng học, nhà khoa học xã hội và các nhà nghiên cứu để đánh giá và cải tiến công nghệ. Công ty cũng có Hội đồng Trách nhiệm AI để đánh giá các hệ thống AI về các nguyên tắc có trách nhiệm và đạo đức, bao gồm các thành kiến, hạn chế tiềm ẩn và các trường hợp sử dụng có hại có thể xảy ra. Cách tiếp cận đa ngành này giúp đảm bảo rằng các công nghệ AI, như phát hiện Deepfake mang lại lợi ích cho con người hơn là gây hại.

Khi Deepfake trở nên phổ biến và tinh vi hơn, việc phát triển và triển khai các công nghệ phát hiện để chống lại thông tin sai lệch và các hậu quả có hại khác ngày càng trở nên quan trọng. Công nghệ phát hiện Deepfake thời gian thực của Phòng thí nghiệm Intel cung cấp một giải pháp hiệu quả và có tiềm năng phát triển cho vấn đề đang gia tăng này.

Bằng cách kết hợp các cân nhắc về đạo đức và cộng tác với các chuyên gia trong nhiều lĩnh vực khác nhau, Intel đang nỗ lực hướng tới một tương lai khi các công nghệ AI được sử dụng một cách có trách nhiệm và phục vụ sự tiến bộ của xã hội.

Nguyễn Anh Tuấn(theo ZDNet)